GitHub - Stratosparkfood-101-keras Класифікація продуктів з глибоким навчанням у Keras Tensorflow

Класифікація продуктів з глибоким навчанням у Керасі/Тенсорфлу

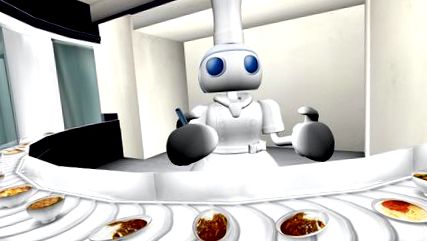

Комп’ютер, що я взагалі їжу?

Якщо ви читаєте це на GitHub, демонстрація виглядає так. Будь ласка, перейдіть за посиланням нижче, щоб переглянути демо-версію в моєму блозі.

ОНОВЛЕННЯ

Зворотні нейронні мережі (CNN), техніка в більш широкому полі глибокого навчання, стали революційною силою в програмах Computer Vision, особливо протягом останнього півріччя або близько того. Одним з основних випадків використання є класифікація зображень, наприклад визначення того, чи є зображення собаки чи кота.

Звичайно, вам не потрібно обмежуватися двійковим класифікатором; CNN можна легко масштабувати до тисяч різних класів, як видно з відомого набору даних ImageNet з 1000 класів, що використовується для порівняння продуктивності алгоритму комп'ютерного зору.

Протягом останніх кількох років ці найсучасніші методи стали доступними для широкого кола розробників програмного забезпечення. Промислові пакети міцності, такі як Tensorflow, дали нам ті самі будівельні блоки, які Google використовує для написання додатків глибокого навчання для вбудованих/мобільних пристроїв у масштабовані кластери в хмарі - без необхідності вручну кодувати операції з матрицею графічного процесора, часткові похідні градієнти та стохастичні оптимізатори які роблять можливими ефективні програми.

Крім усього цього, є зручні API, такі як Keras, які абстрагують деякі деталі нижчого рівня і дозволяють зосередитись на швидкому прототипуванні графіку обчислень глибокого навчання. Подібно до того, як ми змішували і поєднували Legos, щоб отримати бажаний результат.

Як вступний проект для себе, я вирішив використати попередньо навчений класифікатор зображень, який постачається з Керасом, і перекваліфікувати його в наборі даних, який мені здається цікавим. Я дуже люблю гарну їжу та домашню кухню, тому щось подібне було апетитним.

У статті Food-101 - Добування дискримінаційних компонентів із випадковими лісами вони представляють набір даних Food-101. Існує 101 різний клас їжі, з 1000 позначених зображень на клас, доступні для тренованих тренувань.

Мене надихнув цей допис у блозі Keras: Створення потужних моделей класифікації зображень з використанням дуже мало даних та пов’язаний скрипт, який я знайшов на github: keras-finetuning.

Нещодавно я побудував систему для експериментів із глибоким навчанням. Ключовими компонентами є Nvidia Titan X Pascal з 12 ГБ пам'яті, 96 ГБ системної оперативної пам'яті, а також 12-ядерний Intel Core i7. На ньому працює 64-розрядна версія Ubuntu 16.04 та використовується дистрибутив Anaconda Python. На жаль, ви не зможете стежити за цим ноутбуком у власній системі, якщо у вас недостатньо оперативної пам'яті. У майбутньому я хотів би дізнатися, як ефективно обробляти набори даних, більші за обсяг оперативної пам'яті. Будь ласка, зв’яжіться, якщо у вас є якісь ідеї!

Я витратив близько 1 місяця на створення та реалізацію цього проекту, намагаючись навчити десятки моделей та досліджуючи різні сфери, такі як багатопроцесорна обробка для швидшого збільшення зображень. Це вичищена версія блокнота, яка містить мою найкращу модель на 22 січня 2017 року.

Після тонкої настройки попередньо навченої моделі Google InceptionV3 я зміг досягти приблизно 82,03% Точність-1 на тестовому наборі з використанням одного урожаю на одиницю. Використовуючи 10 урожаїв на приклад і беручи найчастіші передбачувані класи, я зміг досягти 86,97% Точність-1 і 97,42% Точність-5

Інші змогли досягти більш точних результатів:

- Завантаження великої кількості даних в пам’ять, як цього уникнути?

- Збереження даних у файлі h5py для позадиапазонної обробки?

- Використання Dask для розподіленої обробки?

- Покращення багатопроцесорного збільшення зображень?

- Експорт у мобільний додаток Tensorflow?

Завантаження та попередня обробка набору даних

Давайте імпортуємо всі пакети, необхідні для решти блокнота:

Завантажте набір даних і розпакуйте його в папці блокнота. Це може бути простіше зробити в окремому вікні терміналу.

Давайте подивимося, які продукти представлені тут:

Давайте розглянемо кілька випадкових зображень з кожного класу продуктів харчування. Ви можете клацнути правою кнопкою миші та відкрити зображення в новому вікні або зберегти його, щоб побачити його з більш високою роздільною здатністю.

Багатопроцесорний басейн буде використовуватися для прискорення збільшення зображень під час тренувань.

Нам потрібні карти від класу до індексу і навпаки для належного кодування етикеток та гарного друку.

Набір даних Food-101 має передбачений розділ на поїзд/випробування. Ми хочемо використовувати це для порівняння нашої продуктивності класифікації з іншими реалізаціями.

Тепер ми готові завантажити навчальні та тестувальні зображення в пам’ять. Після того, як все завантажиться, буде виділено близько 80 ГБ пам'яті.

Будь-які зображення, ширина чи довжина яких менша за мінімальний розмір, будуть змінені. Це для того, щоб ми могли взяти урожай належного розміру під час збільшення зображень.

Нам потрібно одноразово кодувати кожне значення мітки, щоб створити вектор двійкових функцій, а не одну функцію, яка може приймати значення n_classes.

Мені потрібно було мати більш потужний конвеєр для збільшення зображень, ніж той, який постачається з Keras. На щастя, мені вдалося знайти цю змінену версію для використання в якості основи.

Автор додав розширюваний конвеєр, що дозволило вказати додаткові модифікації, такі як власні функції обрізання та можливість використання препроцесора зображення Inception. Вміння застосовувати попередню обробку динамічно було необхідним, оскільки у мене не було достатньо пам’яті, щоб зберегти весь навчальний набір як float32. Я зміг завантажити весь навчальний набір як uint8s .

Крім того, я не використовував повністю свій графічний процесор або багатоядерний процесор. За замовчуванням Python може використовувати лише одне ядро, обмежуючи тим самим кількість оброблених/доповнених зображень, які я міг відправити на графічний процесор для навчання. На основі певного моніторингу продуктивності я використовував лише невеликий відсоток графічного процесора в середньому. Включивши багатопроцесорний пул python, я зміг отримати близько 50% використання процесора та 90% використання графічного процесора.

Кінцевий результат - кожна епоха тренувань тривала від 45 хвилин до 22 хвилин! Ви можете самостійно запускати графічні графічні процесори, навчаючись у цьому зошиті. Натхненням для спроб покращити збільшення даних та продуктивність графічного процесора послужив Джиммі Гуд: буферизовані генератори Python для збільшення даних

На даний момент код досить помилковий і вимагає перезапуску ядра Python щоразу, коли навчання переривається вручну. Код досить зломлений, і деякі функції, такі як ті, що стосуються підгонки, відключені. Я сподіваюся вдосконалити цей ImageDataGenerator і випустити його для спільноти в майбутньому.

Ми можемо побачити, які типи зображень виходять із цих ImageDataGenerators:

Ми перекваліфікуємо модель Google InceptionV3, попередньо підготовлену на ImageNet. Архітектура нейронної мережі показана нижче.

На даний момент ми бачимо до 81,65 одноразової точності Топ-1 на тестовому наборі. Ми можемо продовжувати тренувати модель на ще повільнішому рівні навчання, щоб перевірити, чи покращується вона більше.

У моїх початкових експериментах використовувались більш сучасні оптимізатори, такі як Адам та АдаДельта, поряд із вищими показниками навчання. Я затримався на деякий час нижче 80% точності, перш ніж я вирішив уважніше стежити за літературою та використовувати стохастичний градієнтний спуск (SGD) із швидко зменшуючимся графіком навчання. Коли ми шукаємо багатовимірну поверхню, інколи повільніше йде довгий шлях.

Через деяку нестабільність мого багатопроцесорного коду, іноді мені потрібно перезапустити ноутбук, завантажити останню модель, а потім продовжити навчання.

На даний момент ми повинні мати кілька навчених моделей, збережених на диску. Ми можемо пройти їх і використовувати функцію load_model для завантаження моделі з найменшими втратами/найвищою точністю.

Ми також хочемо оцінити набір тестів, використовуючи кілька культур. Це може підвищити точність на 5% у порівнянні з оцінкою одного врожаю. Зазвичай використовують такі культури: верхній лівий, верхній правий, нижній лівий, нижній правий, центр. Ми також беремо ті самі культури на зображенні, перевернутому зліва направо, загалом створюючи 10 культур.

Крім того, ми хочемо повернути прогнози верхнього N для кожної культури, щоб, наприклад, розрахувати точність Top-5.

Нам також потрібно попередньо обробити зображення для початкової моделі:

Тепер ми створюємо врожаї для кожного елемента тестового набору та отримуємо прогнози. На даний момент це повільний процес, оскільки я не користуюся перевагами багатопроцесорної обробки чи інших типів паралелізму.

Тепер у нас є набір з 10 передбачень для кожного зображення. За допомогою гістограми я бачу, як розподіляється # унікальних прогнозів для кожного зображення.

Давайте створимо словник для зіставлення індексу тестового завдання з його прогнозами топ-1/топ-5.

Матриця плутанини побудує графік кожної мітки класу та скільки разів вона була правильно позначена порівняно з іншими випадками, коли вона була неправильно позначена як інший клас.

Ми хочемо перевірити, чи була точність однаковою у всіх класах, чи деякі класи було набагато простіше/важче позначити, ніж інші. Згідно з нашим сюжетом, кілька класів були вищими з точки зору того, що їх було набагато складніше правильно позначити.

- Копайте, вирощуйте, їжте це Шкільні сади підтримують навчання та здоровіший вибір їжі - Green Blog -

- Глибоке навчання недостатньо, нам потрібне глибоке байєсівське навчання для безпечного ШІ - додому

- Смажені кальмари з часником і лимонним майонезом - BBC Food

- Сирна кальцоне з мережею рецептів салямі з шинкою та Генуєю

- Енергія - як обчислюються калорії в їжі Обмін стеками фізики