Представляємо DIET: ультрасучасна архітектура, яка перевершує тонку настройку BERT і в 6 разів швидше навчається

У Rasa ми дуже раді зробити доступними передові технології машинного навчання у зручному для розробників робочому процесі. Завдяки Rasa 1.8 наша дослідницька група випускає нову надсучасну полегшену багатозадачну архітектуру трансформатора для NLU: Dual Intent and Entity Transformer (DIET).

У цій публікації ми поговоримо про особливості дієти та про те, як ви можете використовувати її в Rasa для досягнення більшої точності, ніж будь-що, що було у нас раніше. Ми випускаємо наукову роботу, яка демонструє, що ця нова архітектура покращує сучасний стан техніки, перевершує тонку настройку BERT і в шість разів швидше навчається.

Що таке ДІЄТА

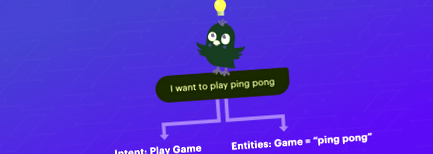

DIET - це багатозадачна трансформаторна архітектура, яка разом обробляє як класифікацію намірів, так і розпізнавання сутності. Він надає можливість підключати та відтворювати різні попередньо навчені вставки, такі як BERT, GloVe, ConveRT тощо. У наших експериментах не існує жодного набору вбудовувань, який би незмінно був найкращим у різних наборах даних. Тому модульна архітектура особливо важлива.

Навіщо використовувати дієту

Масштабні попередньо навчені мовні моделі не є ідеальними для розробників, що створюють розмовні програми ШІ.

Дієта відрізняється тим, що вона:

- Це модульна архітектура, яка вписується в типовий робочий процес розробки програмного забезпечення

- Паралельно великим заздалегідь навченим мовним моделям у точності та продуктивності

- Покращує сучасний рівень техніки і в 6 разів швидше тренується

Широкомасштабні попередньо навчені мовні моделі показали багатообіцяючі результати щодо тестів розуміння мови, таких як GLUE та SuperGLUE, і, зокрема, показали значні вдосконалення в порівнянні з іншими методами попередньої підготовки, такими як GloVe та контрольовані підходи. Оскільки ці вбудовування проводяться у великих корпусах текстових текстів на природній мові, вони добре підготовлені для узагальнення різних завдань.

Минулого року я допоміг створити асистента довідкової служби, який би автоматизував бесіди та повторювані ІТ-процеси. Ми інтегрували помічника з BERT, оскільки на той момент BERT та інші великі мовні моделі досягали високих показників у різноманітних завданнях NLP. Хоча це допомогло вирішити деякі проблеми, BERT також представив власні проблеми; це було дуже повільно, і для тренування потрібен був графічний процесор.

Масштабні моделі, як правило, вимагають обчислень, вимагають багато часу для навчання та представляють практичні завдання для розробників програмного забезпечення, які хочуть створити надійних помічників ШІ, яких можна швидко навчити та повторити. Більше того, якщо ви створюєте багатомовних асистентів ШІ, важливо досягти високого рівня продуктивності без масштабної попередньої підготовки, оскільки більшість попередньо навчених моделей навчаються на англійській мові.

До DIET конвеєр NLU Rasa використовував модель мішка слів, де на кожне повідомлення користувача припадав один векторний елемент. Незважаючи на те, що це швидкий, важкий для подолання базовий рівень, ми зараз вийшли за його межі.

DIET використовує модель послідовності, яка враховує порядок слів, забезпечуючи тим самим кращу продуктивність. Це також більш компактна модель із модульною архітектурою plug-and-play. Наприклад, ви можете використовувати DIET для класифікації намірів та вилучення сутності; Ви також можете виконати одне завдання, наприклад, налаштувати його, щоб вимкнути класифікацію намірів і навчити його лише для вилучення сутності.

ілюстрація високого рівня дієти

Крім того, DIET не тільки значно швидше навчається, але й паралельно виконує масштабні попередньо навчені мовні моделі. Він перевершує точну настройку BERT і покращує сучасний рівень техніки у складному наборі даних NLU. Досягнення сучасної точності може вже не означати жертвування ефективністю.

Як користуватися дієтою

Щоб підготуватися до дієти, ми перейшли на Tensorflow 2.1. TF 2 спрощує створення та навчання моделей та інтуїтивне налагодження проблем.

Для того, щоб зробити класифікацію намірів та вилучення сутності за допомогою нової архітектури DIET, додайте компонент DIETClassifier у файл конфігурації конвеєра NLU.

Ось файл конфігурації, який створюється під час виклику rasa init .

Давайте подивимось на DietClassifier та його залежності. Класифікатор DIETClassifier залежить від двох класів масляних речовин - щільних та рідких. Функціоналізація - це процес перетворення повідомлень користувачів у числові вектори. Ключова відмінність між розрідженими та щільними функціональними елементами полягає в тому, що розріджені функціональні засоби ущільнюють вектори функцій, які містять переважно нулі в структурі з ефективною пам'яттю. Якщо ви хочете дізнатись більше про використання розріджених функцій, перегляньте цю публікацію.

ConveRTFeaturizer - приклад щільного Featurizer, який використовує модель ConveRT. LanguageModelFeaturizer - ще один приклад щільного Featurizer, який використовує попередньо навчену мовну модель, таку як BERT.

CountVectorsFeaturizer - приклад розрідженого Featurizer. Він може бути налаштований на використання n-грамів слова або символу. LexicalSyntacticFeaturizer - ще один приклад розрідженого Featurizer. Він створює функції для вилучення сутності за допомогою розсувного вікна над кожним маркером у даному повідомленні користувача. Компонент LexicalSyntacticFeaturizer можна налаштувати для вказівки типу лексичних та синтаксичних особливостей для вилучення.

Крім того, DIETClassifer можна точно налаштувати за допомогою різних гіперпараметрів. Наприклад, ви можете налаштувати архітектуру нейронної мережі, вказавши розмір трансформатора, кількість шарів трансформатора, кількість головок уваги для використання тощо.

Якщо ви переходите на версію Rasa 1.8, перегляньте інструкції з перенесення. Як завжди, ми закликаємо кожного визначити свій конвеєр, вказавши назви компонентів, які ви хочете використовувати.

Наступні кроки

Ми дуже раді DIET, новій багатозадачній трансформаторній архітектурі, яку ми винайшли. Ми випустили його з двох причин: створення ефективних асистентів ШІ не завжди вимагає масштабних попередньо навчених мовних моделей, і ми хотіли надати гнучку архітектуру plug-and-play для розробників. DIET вдосконалює сучасний рівень техніки, перевершує точну настройку BERT і в шість разів швидше тренується.

Незабаром ми випустимо статтю про це. До цього часу перевірте більше інформації про дієту та перегляньте це відео про те, як це працює. Спробуйте і поділіться своїми результатами на форумі. Слідкуйте за новими подіями, слідкуючи за Rasa у Twitter.

- C C diff Curable C diff Дієта для швидшого відновлення; DrFormulas

- Високо насичена жирами дієта з високим вмістом цукру прискорює дисфункцію лівого шлуночка швидше, ніж

- ЯК ВАША ДІЄТА МОЖЕ ЗРОБИТИ АБО ЗРОБИТИ ПЕРШИЙ ДОСВІД ТАТУ - Татуювання Celebrity Ink ™

- Як ваша дієта шкодить вашій шкірі - регенеративні методи лікування

- Як дієта тварин впливає на ваше здоров’я Те, що їдять курчата, впливає на харчову цінність яєць